Всем привет, друзья! Сегодня я расскажу, как создать файл robots txt для wordpress. Этот пост, будет очень важным для тех, у кого до сих пор нет файла robots txt. Я постараюсь рассказать вам основные команды, которые используются в этом файле, чтобы вы могли составить самостоятельно robots txt а также покажу пример, каким должен быть правильный robots.txt для wordpress:smile:.

http://www.mycharm.ru/articles/text/?id=2766

то нужно просто убрать из файла robots.txt вот эту строчку

Disallow: /*?*

, поскольку она заблокирует индексацию всех страниц, где встречается знак вопроса «?»

. Ее нужно убрать в двоих местах.

Как составить правильный robots.txt самому?

Если у вас другая система управления сайтом, то я вам сейчас кратко расскажу основные команды для того, чтобы вы могли составить robots.txt для своего сайта самостоятельно. Итак, поехали.

Директива «User-agent» отвечает за то, к какому поисковому роботу вы обращаетесь.

- User-agent: * — ко всем поисковикам;

- User-agent: Yandex – только к Яндексу;

- User-agent: Googlebot – только к Гуглу;

Директива «Disallow»

закрывает страницы, категории или сайт от индексации.

Например, у меня есть на сайте вод такая страница http://сайт/search/

и я хочу закрыть ее от индексации всех поисковиков. В таком случаи нужно прописать следующее.

User-agent: *

Disallow: /search/

Если вы хотите закрыть весь сайт от индексации гуглом, то нужно прописать так:

User-agent: Googlebot

Disallow: /

А если, наоборот, хотите, чтобы весь сайт индексировался гуглом, то нужно прописать в файле robots.txt вод так:

User-agent: Googlebot

Disallow:

Таким образом, мы можем запретить индексировать сайт или страницу, яндексу и гулу отдельно, или всем поисковикам сразу.

Директива «Allow»

разрешает индексировать сайт, категории или страницы.

Например, вы хотите запретить индексировать папку wp-includes всем поисковикам, но в этой папке хотите разрешить индексировать файл compat.php, тогда нужно прописать следующее:

User-agent: *

Disallow: /wp-includes/

Allow: /wp-includes/compat.php

Директива «Sitemap» позволяет указать поисковым роботам:

User-agent: *

Sitemap: http://сайт/sitemap.xml

Есть еще несколько директив, которые понимает только Яндекс.

Директива «Host» позволяет указать основной адрес сайта. С www или без www. Я указал без www.

User-agent: Yandex

Host: сайт

Директива «Crawl-delay»

позволяет указать задержку, с которой поисковый робот будет отправлять вам команду. Если у вас большой сайт, то поисковик постоянным его штудированием может создать большую нагрузку на сервер. И чтобы этого не случилось, вы можете воспользоваться директивой «Crawl-delay»

Вод пример:

User-agent: Yandex

Crawl-delay: 3

Это значит, что интервал между посылками команды будет 3 секунды. Но опять же, это актуально только для яндекса.

Для того, чтобы без проблем самому составить файл robots.txt, очень важно научиться понимать некоторые спецсимволы. Адрес начинается с третьего слеша.

- Символ * — любая, последовательность символов.

- Символ $ — конец строки.

Я сейчас объясню, что это значит, и как эти символы использовать при составлении файла robots.txt

Сначала разберем, как использовать «*». Например, у меня есть дублирована страница

http://сайт/page?replytocom=29#respond

Для того, чтобы убрать ее с индекса нужно прописать следующее:

User-agent: *

Disallow: /*?*

Таким образом, я говорю поисковому роботу: «Если в URL страницы встретишь знак вопроса «?» то не индексируй ее. И неважно, какие символы стоят до знака вопроса и после него».

Потому что перед знаком вопроса и после него мы поставили звездочку «*». А она, в свою очередь, означает любую последовательность символов.

Ну а теперь разберем, как использовать символ $. Например, у нас есть вод такая страница

http://сайт/index.php

и мы хотим запретить поисковому роботу ее индексировать.

Для этого нужно прописать следующее

User-agent: *

Disallow: /*index.php$

Я говорю поисковикам: «Если index.php конец строки и неважно какие символы до index.php – не индексируй». Пояснил, как мог, если что-то не понятно, то спрашивайте в комментариях;-).

Таким образом, зная всего лишь эти два спецсимволы, можно запрещать от индексации любую страницу или раздел сайта.

Как убедиться в том, что мы составили правильный robots.txt?

Для этого, прежде всего, нужно . Потом, нужно зайти в раздел: «Настройка индексирования» — «Анализ robots.txt».

После этого нужно загрузить файл robots.txt и нажать на кнопку проверить. Если вы увидите примерно такое сообщения, как на картинке, без ошибок, значит у вас правильный robots.txt для wordpress или другой системы управления.

Но мы еще можем проверить конкретную страницу. Например, я копирую url статьи, которая должна быть открыта для индексации, и проверяю, так ли это на самом деле.

Подробная инструкция о том, как создать файл robots.txt для сайта. Robots.txt является одним из самых необходимых аспектов полноценной поисковой оптимизации сайта. Соблюдая условия грамотного использования этого файла, можно достичь определенного положительного эффекта на сайт. Возможно указание разнообразных инструкций для большинства PS. Которые указывают поисковому боту необходимые ограничения или разрешения на сканирование страниц, каталогов или разделов сайта.

Содержание статьи:

Файл Robots.txt — основное определение

Robots.txt — имеет определенные стандарты исключений для поисковых агентов (ботов), который был принят в январе 1944 года. Правилам этого файла добровольно следуют самые распространенные PS. Файл может состоять из одного или нескольких правил, каждое из которых блокирует или разрешает поисковому роботу доступ к определенным путям на сайте.

По умолчанию этого файла нет на сайте — что дает всем PS полное разрешение на индексирование всего содержимого сайта. Такое разрешение может привести к попаданию в индекс поисковиков важных технических страниц сайта, которых там быть не должно.

Для чего нужен Robots.txt на сайте — его влияние на продвижение в поисковиках

Robots.txt — это наиважнейший фактор поисковой оптимизации сайта. Благодаря правильно прописанному набору правил для поисковых ботов, можно достичь определенного повышения ранжирования сайта в поиске. Что дают такие инструкции:

- Заперты на индексирование определенных страниц, разделов, каталогов сайта.

- Исключение страниц не содержащих полезного контента.

- Исключение дублей страниц и прочее.

Для большинства сайтов, такие ограничения на индексирование просто необходимы для небольших полностраничных необязательны. Тем не менее определенные директивы, необходимо добавлять каждому сайту. К примеру запреты на индексацию:

- Страниц регистрации, входа в админку, восстановления пароля.

- Технических каталогов.

- Rss — ленты сайта.

- Replytocom и прочего.

Как создать правильный Robors.txt самостоятельно

Затруднений при создании файла Robots.txt не может возникнуть даже у начинающих. Достаточно следовать определенной последовательности действий:

- Robots.txt — текстовый документ и создается любым доступным текстовым редактором.

- Расширение файла должно быть обязательно.txt.

- Название обязательно robots.

- На одном сайте, разрешен только один такой файл.

- Размещается только в корневом каталоге сайта.

Вам необходимо воспользоваться обыкновенным текстовым редактором (блокнотом как альтернативой). Создаем документ формата.txt и названием robots. Затем сохраняем и переносим этот документ с помощью FTP клиента в корневой каталог сайта. Это основные действия которые необходимо выполнить.

Создание Robots.txt с помощью онлайн сервисов

Этот метод самый простой и быстрый, подойдет тем кто боится самостоятельно создавать Robots.txt или просто ленится. Сервисов предлагающих создание этого файла огромное множество. Но стоит учитывать некоторые нюансы касательно этого способа. К примеру:

- Необходимо заранее учесть, что именно Вы желаете запретить, либо разрешить агенту.

- Необходима обязательная проверка готового файла перед загрузкой его на сайт.

- Будьте внимательны, ведь некорректно созданный файл Robots.txt online, приведет к плачевной ситуации. Таким образом в поиск могут попасть, технические и прочие страницы сайта, которых там быть в априори не должно.

Все таки, лучше потратить время и усилия для создания корректного пользовательского роботса. Таким образом можно воссоздать четко обоснованную структуру запретов и разрешений соответствующую вашему сайту.

Редактирование и правильный синтаксис файла Robots.txt

После успешно созданного Robots.txt, его можно спокойно редактировать и изменять как Вам будет угодно. При этом следует учесть некоторые правила и грамотный синтаксис. По прошествии некоторого времени вы неоднократно будете изменять этот файл. Но не забывайте, после проведения работ по редактированию, Вам необходимо будет выгрузить этот файл на сайт. Тем самым обновив его содержимое для поисковых роботов.

Написать Robots.txt очень просто, причина этому достаточно простая структура оформления данного файла. Главное при написании правил, использовать строго определенный синтаксис. Данным правилам добровольно следуют, практически все основные ПС. Вот список некоторых правил, для избежания большинства ошибок в файле Robots.txt:

- В одной строке не должно быть более одной указанной директивы.

- Каждое правило начинается с новой строки.

- Исключен пробел в начале строки.

- Допустимы комментарии после символа #.

- Пустой Роботс будет считаться как полное разрешение на индексацию.

- Название этого файла возможно только в допустимом формате «robots».

- Размер файла не должен превышать 32кб.

- В директивах Allow и Disallow допустимо только одно правило. Пустое значение после Allow: или Disallow: равносильны полному разрешению.

- Все правила должны быть прописаны в нижнем регистре.

- Файл должен быть доступен всегда.

- Пустая строка после указанных правил, указывает на полное окончание правил директивы User-agent.

- Желательно прописывать правила, каждой ПС по отдельности.

- Если правило это директория сайта, то обязательно ставьте слеш (/) перед ее началом.

- Кавычек в строке или в правиле быть не должно.

- Необходимо учитывать строгую структуру правил, соответствующую Вашему сайту не более.

- Robots.txt должен быть минималистичен и четко отображать передаваемый смысл.

Грамотная настройка файла Robots.txt — правильное написание команд

Чтобы получить позитивный результат при использовании роботс, необходимо правильно его настроить. Всем основным командам данного файла с инструкциями, следуют самые масштабные поисковые системы Google and Yandex. Остальные PS могут игнорировать некоторые инструкции. Как сделать robots.txt наиболее отзывчивым большинству поисковиков? Здесь необходимо понимание основных правил работы с этим файлом о которых говорилось выше.

Рассмотрим основные команды:

User-Agent: * — инструкции будут касаться абсолютно всех ps ботов. Также возможно указание определенных поисковых систем по отдельности к примеру: User-Agent: GoogleBot и User-Agent: YandexBot. Таким образом корректно обозначаются правила для важных ПС.

Disallow: — полностью запрещает обход и индексацию (страницы, каталога или файлов).

Allow: — полностью разрешает обход и индексацию (страницы, каталога или файлов).

Clean-param: — нужен для исключения страниц сайта с динамическим контентом. Благодаря этому правилу можно избавиться от дублей контента на сайте.

Crawl-delay: — правило указывает интервал времени п-ботам для выгрузки документов с сайта. Позволяет значительно уменьшить нагрузки на сервер. К примеру: «Crawl-delay: 5» — скажет п-роботу, что скачивание документов с сайта возможно не чаще 1-го раза в 5 секунд.

Host: ваш_сайт.ru — отвечает за главное зеркало сайта. В этой директиве необходимо прописать приоритетную версию сайта.

Sitemap: http://ваш_сайт.ru/sitemap.xml — как Вы могли догадаться данная директива подсказывает п-боту о наличие Sitemap на сайте.

# — позволяет оставлять комментарии. Комментировать можно, только после знака решетки. Размещать ее можно как в новой строке, так и продолжением директивы. Все эти варианты будут игнорироваться ботами при проходе инструкций.

Примеры Robots.txs для всех основных систем управления контентом (CMS)

Чтобы скопировать инструкции, Вам необходимо нажать на кнопку с подсказкой.

WordPress (WP)

User-Agent: *

Allow: /wp-content/uploads/

Disallow: /wp-login.php

Disallow: /wp-register.php

Disallow: /xmlrpc.php

Disallow: /template.html

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content

Disallow: /category

Disallow: /archive

Disallow: */trackback/

Disallow: */feed/

Disallow: */comments/

Disallow: /?feed=

Host: site.ru

»

HostCMS

User-agent: *

Disallow: captcha.php

Disallow: download_file.php

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

Joomla

User-agent: *

Disallow: /administrator/

Disallow: /cache/

Disallow: /components/

Disallow: /images/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /libraries/

Disallow: /media/

Disallow: /modules/

Disallow: /plugins/

Disallow: /templates/

Disallow: /xmlrpc/

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

Joomla 3

User-agent: *

Disallow: /administrator/

Disallow: /cache/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /libraries/

Disallow: /media/

Disallow: /modules/

Disallow: /plugins/

Disallow: /templates/

Disallow: /xmlrpc/

MODx Evo

User-agent: *

Disallow: /assets/cache/

Disallow: /assets/docs/

Disallow: /assets/export/

Disallow: /assets/import/

Disallow: /assets/modules/

Disallow: /assets/plugins/

Disallow: /assets/snippets/

Disallow: /install/

Disallow: /manager/

Disallow: /index.php

Host: vash_sait.ru (или www.vash_sait.ru)

Sitemap: http://путь к вашей карте XML формата

NetCat

User-Agent: *

Disallow: /install/

Disallow: /links/

Disallow: /netcat/

Disallow: /netcat_files/

Disallow: /*.swf

Host: vash_sait.ru (или www.vash_sait.ru)

Sitemap: http://путь к вашей карте XML формата

MODx

User-agent: *

Disallow: /assets/cache/

Disallow: /assets/docs/

Disallow: /assets/export/

Disallow: /assets/import/

Disallow: /assets/modules/

Disallow: /assets/plugins/

Disallow: /assets/snippets/

Disallow: /install/

Disallow: /manager/

Host: site.ru

Sitemap: http://site.ru/sitemap.xml

OpenCart

User-agent: *

Disallow: /*route=account/

Disallow: /*route=affiliate/

Disallow: /*route=checkout/

Disallow: /*route=product/search

Disallow: /index.php?route=product/product*&manufacturer_id=

Disallow: /admin

Disallow: /catalog

Disallow: /download

Disallow: /export

Disallow: /system

Disallow: /*?sort=

Disallow: /*&sort=

Disallow: /*?order=

Disallow: /*&order=

Disallow: /*?limit=

Disallow: /*&limit=

Disallow: /*?filter_name=

Disallow: /*&filter_name=

Disallow: /*?filter_sub_category=

Disallow: /*&filter_sub_category=

Disallow: /*?filter_description=

Disallow: /*&filter_description=

Disallow: /*?tracking=

Disallow: /*&tracking=

Disallow: /*?page=

Disallow: /*&page=

Disallow: /wishlist

Disallow: /login

Disallow: /index.php?route=product/manufacturer

Disallow: /index.php?route=product/compare

Disallow: /index.php?route=product/category

Host: vash_sait.ru (или www.vash_sait.ru)

UMI

User-Agent: *

Disallow: /emarket/addToCompare

Disallow: /emarket/basket

Disallow: /go_out.php

Disallow: /images

Disallow: /images/lizing

Disallow: /images/ntc

Disallow: /files

Disallow: /users

Disallow: /admin

Disallow: /search

Disallow: /install-temp

Disallow: /install-static

Disallow: /install-libs

Host: vash_sait.ru (или www.vash_sait.ru)

Sitemap: http://путь к вашей карте XML формата

Amiro.CMS

User-agent: *

Disallow: /admin

Disallow: /_admin/

Disallow: /members

Disallow: /search

Disallow: /subscribe

Disallow: /users

Disallow: /*offset=0

Disallow: /*forum_ext=

Disallow: /*_print_version=

Disallow: /*action=export_rss

Disallow: /*action=search

Disallow: /*action=view_posts

Disallow: /*display_form=

Host: site.ru

Sitemap: http://site.ru/sitemap.xm

Bitrix

User-agent: *

Disallow: /*index.php$

Disallow: /bitrix/

Disallow: /auth/

Disallow: /personal/

Disallow: /upload/

Disallow: /search/

Disallow: /*/search/

Disallow: /*/slide_show/

Disallow: /*/gallery/*order=*

Disallow: /*?print=

Disallow: /*&print=

Disallow: /*register=

Disallow: /*forgot_password=

Disallow: /*change_password=

Disallow: /*login=

Disallow: /*logout=

Disallow: /*auth=

Disallow: /*?action=

Disallow: /*action=ADD_TO_COMPARE_LIST

Disallow: /*action=DELETE_FROM_COMPARE_LIST

Disallow: /*action=ADD2BASKET

Disallow: /*action=BUY

Disallow: /*bitrix_*=

Disallow: /*backurl=*

Disallow: /*BACKURL=*

Disallow: /*back_url=*

Disallow: /*BACK_URL=*

Disallow: /*back_url_admin=*

Disallow: /*print_course=Y

Disallow: /*COURSE_ID=

Disallow: /*?COURSE_ID=

Disallow: /*?PAGEN

Disallow: /*PAGEN_1=

Disallow: /*PAGEN_2=

Disallow: /*PAGEN_3=

Disallow: /*PAGEN_4=

Disallow: /*PAGEN_5=

Disallow: /*PAGEN_6=

Disallow: /*PAGEN_7=

Disallow: /*PAGE_NAME=search

Disallow: /*PAGE_NAME=user_post

Disallow: /*PAGE_NAME=detail_slide_show

Disallow: /*SHOWALL

Disallow: /*show_all=

Host: vash_sait.ru (или www.vash_sait.ru)

Sitemap: http://путь к вашей карте XML формата

Drupal

User-agent: *

Disallow: /database/

Disallow: /includes/

Disallow: /misc/

Disallow: /modules/

Disallow: /sites/

Disallow: /themes/

Disallow: /scripts/

Disallow: /updates/

Disallow: /profiles/

Disallow: /profile

Disallow: /profile/*

Disallow: /xmlrpc.php

Disallow: /cron.php

Disallow: /update.php

Disallow: /install.php

Disallow: /index.php

Disallow: /admin/

Disallow: /comment/reply/

Disallow: /contact/

Disallow: /logout/

Disallow: /search/

Disallow: /user/register/

Disallow: /user/password/

Disallow: *register*

Disallow: *login*

Disallow: /top-rated-

Disallow: /messages/

Disallow: /book/export/

Disallow: /user2userpoints/

Disallow: /myuserpoints/

Disallow: /tagadelic/

Disallow: /referral/

Disallow: /aggregator/

Disallow: /files/pin/

Disallow: /your-votes

Disallow: /comments/recent

Disallow: /*/edit/

Disallow: /*/delete/

Disallow: /*/export/html/

Disallow: /taxonomy/term/*/0$

Disallow: /*/edit$

Disallow: /*/outline$

Disallow: /*/revisions$

Disallow: /*/contact$

Disallow: /*downloadpipe

Disallow: /node$

Disallow: /node/*/track$

Disallow: /*?page=0

Disallow: /*section

Disallow: /*order

Disallow: /*?sort*

Disallow: /*&sort*

Disallow: /*votesupdown

Disallow: /*calendar

Disallow: /*index.php

Host: vash_sait.ru (или www.vash_sait.ru)

Sitemap: http://путь к вашей карте XML формата

Как проверить Robots.txt с помощью Google или Yandex

Как не странно для проверки этого файла необходимы только панели вебмастера Google или Yandex. Что в свою очередь значительно облегчает поиск ошибок.

Вебмастер Google — выбираем в левом меню «Сканирование» и затем вкладку «Инструмент проверки файла Robots.txt». Затем в нижней строке появившегося окна допишите название файла. Затем нажмите на «Проверить» и посмотрите как бот гугла видит Ваш роботс.

Вебмастер Yandex — в левом меню выбираем «Инструменты» и «Анализ Robots.txt». После этого в появившимся окне просто нажмите на кнопку «Проверить».

Стоит отметить, что онлайн валидаторов для проверки этого файла очень много. Я рассказал о самых доступных, которые находятся всегда под рукой.

Заключение

Написать один идеальный robots для всех сайтов невозможно. Причина этому сами сайты, некоторые из которых сделаны руками, а другие расположены на различных CMS. У абсолютно всех сайтов различная структура каталогов и прочего. Поэтому каждый Вебмастер просто обязан создать свой уникальный набор правил для п-ботов. Такой файл будет отвечать Вашим приоритетам и не позволит попасть в поиск конфиденциальной информации. Благодаря этому в индексе будет находиться качественный контент без лишнего мусора.

Приветствую вас, уважаемые читатели SEO блога Pingo. В данной статье я хочу изложить своё представление о том, как правильно составить robots.txt для сайта. В своё время меня очень раздражало, что информация в интернете по этому вопросу довольно отрывочна. Из-за этого приходилось ползать по большому количеству ресурсов, постоянно фильтруя повторяющуюся информацию и вычленяя новую.

Таким образом, здесь я постараюсь ответить на большинство вопросов, начиная с определения и заканчивая примерами реальных задач, решаемых данным инструментом. Если что-то забуду - отпишитесь в комментариях об этом - исследую вопрос и дополню материал.

Robots.txt - что это, зачем нужен и где обитает?

Итак, сперва ликбез для тех, кому данная тема незнакома совершенно.

Robots.txt - текстовый файл, содержащий инструкции по индексации сайта для роботов поисковых систем. В этом файле вебмастер может определить параметры индексации своего сайта как для всех роботов сразу, так и для каждой поисковой системы по отдельности (например, для гугла).

Где находится robots.txt? Он размещается в корневой папке FTP сайта, и, по сути, является обычным документом в формате txt, редактирование которого можно осуществлять через любой текстовый редактор (лично я предпочитаю Notepad++). Содержимое файла роботс можно увидеть, введя в адресной строке браузера http://www.ваш-сайт.ru/robots.txt. Если, конечно, он существует.

Как создать robots.txt для сайта? Достаточно сделать обычный текстовый файл с таким именем и загрузить его на сайт. О том, как его правильно настроить и составить, будет сказано ниже.

Структура и правильная настройка файла robots.txt

Как должен выглядеть правильный файл robots txt для сайта? Структуру можно описать следующим образом:

1. Директива User-agent

Что писать в данном разделе? Эта директива определяет то, для какого именно робота предназначены нижеизложенные инструкции. Например, если они предназначены для всех роботов, то достаточно следующей конструкции:

В синтаксисе файла robots.txt знак «*» равноценен словосочетанию «что угодно». Если же требуется задать инструкции для конкретной поисковой системы или робота, то на месте звездочки из предыдущего примера пишется его название, например:

User-agent: YandexBot

У каждого поисковика существует целый набор роботов, выполняющих те или иные функции. Роботы поисковой системы Яндекс описаны . В общем же плане имеется следующее:

- Yandex - указание на роботов Яндекс.

- GoogleBot - основной индексирующий робот .

- MSNBot - основной индексирующий робот Bing.

- Aport - роботы Aport.

- Mail.Ru - роботы ПС Mail.

Если имеется директива для конкретной поисковой системы или робота, то общие игнорируются.

2. Директива Allow

Разрешает отдельные страницы раздела, если, скажем, ранее он целиком закрыт от индексации. Например:

User-agent: *

Disallow: /

Allow: /открытая-страница.html

В данном примере мы запрещаем к индексации весь сайт, кроме страницы poni.html

Служит эта директива в какой-то степени для указания на исключения из правил, заданных директивой Disallow. В случае, если таких ситуаций нет, то директива может не использоваться совсем. Она не позволяет открыть сайт для индексации, как многие думают, так как если нет запрета вида Disallow: /, то он открыт по умолчанию.

2. Директива Disallow

Является антиподом директивы Allow и закрывает от индексации отдельные страницы, разделы или сайт целиком. Являет аналогом тега noindex. Например:

User-agent: *

Disallow: /закрытая-страница.html

3. Директива Host

Используется только для Яндекса и указывает на основное зеркало сайта. Выглядит это так.

Основное зеркало без www:

Основное зеркало с www:

Host: www.site.ru

Сайт на https:

Host: https://site.ru

Нельзя записывать директиву host в файл дважды. Если же вследствие какой-то ошибки это произошло, то обрабатывается та директива, которая идет первой, а вторая - игнорируется.

4. Директива Sitemap

Используется для указания пути к XML-карте сайта sitemap.xml (если она есть). Синтаксис следующий:

Sitemap: http://www.site.ru/sitemap.xml

5. Директива Clean-param

Используется для закрытия от индексации страниц с параметрами, которые могут являться дублями. Очень полезная на мой взгляд директива, которая отсекает параметрический хвост урлов, оставляя только костяк, который и является родоначальным адресом страницы.

Особенно часто встречается такая проблема при работе с каталогами и интернет-магазинами.

Скажем, у нас имеется страница:

http://www.site.ru/index.php

И эта страница в процессе работы может обрастать клонами вида.

http://www.site.ru/index.php?option=com_user_view=remind

http://www.site.ru/index.php?option=com_user_view=reset

http://www.site.ru/index.php?option=com_user_view=login

Для того, чтобы избавиться от всевозможных вариантов этого спама, достаточно указать следующую конструкцию:

Clean-param: option /index.php

Синтаксис из примера, думаю, понятен:

Clean-param: # указываем директиву

option # указываем спамный параметр

/index.php # указываем костяк урла со спамным параметром

Если параметров несколько, то просто перечисляем их через амперсант(&):

http://www.site.ru/index.php?option=com_user_view=remind&size=big # урл с двумя параметрами

Clean-param: option&big /index.php # указаны два параметра через амперсант

Пример взят простой, поясняющий саму суть. Особенно спасибо этому параметру хочется сказать при работе с CMS Bitrix.

Директива Crawl-Delay

Позволяет задать таймаут на загрузку страниц сайта роботом Яндекс. Используется при большой загруженности сервера, при которой он просто не успевает быстро отдавать содержимое. На мой взгляд, это анахронизм, который уже не учитывается и который можно не использовать.

Crawl-delay: 3.5 #таймаут в 3,5 секунды

Синтаксис

- # - используется для написания комментариев:

- * - означает любую последовательность символов, значение:

- $ - обрезание правила, антипод знака звездочки:

User-agent: * # директива относится ко всем роботам

Disallow: /page* # запрет всех страниц, начинающихся на page

Disallow: /*page # запрет всех страниц, заканчивающихся на page

Disallow: /cgi-bin/*.aspx # запрет всех aspx страниц в папке cgi-bin

Disallow: /page$ # будет закрыта только страница /page, а не /page.html или pageline.html

Пример файла robots.txt

С целью закрепления понимания вышеописанной структуры и правил, приведем стандартный robots txt для CMS Data Life Engine.

User-agent: * # директивы предназначены для всех поисковых систем

Disallow: /engine/go.php # запрещаем отдельные разделы и страницы

Disallow: /engine/download.php #

Disallow: /user/ #

Disallow: /newposts/ #

Disallow: /*subaction=userinfo # закрываем страницы с отдельными параметрами

Disallow: /*subaction=newposts #

Disallow: /*do=lastcomments #

Disallow: /*do=feedback #

Disallow: /*do=register #

Disallow: /*do=lostpassword #

Host: www.сайт # указываем главное зеркало сайта

Sitemap: https://сайт/sitemap.xml # указываем путь до карты сайта

User-agent: Aport # указываем направленность правил на ПС Aport

Disallow: / # предположим, не хотим мы с ними дружить

Проверка robots.txt

Как проверить robots txt на корректность составления? Стандартный вариант - валидатор Яндекса - http://webmaster.yandex.ru/robots.xml . Вводим путь до вашего файла роботс или сразу вставляем его содержимое в текстовое поле. Вводим список урлов, которые мы хотим проверить - закрыты или открыты они согласно заданным директивам - нажимаем «Проверить» и вуаля! Профит.

Выводится статус страницы - открыта ли она для индексации или закрыта. Если закрыта, то указывается, каким именно правилом. Чтобы разрешить индексацию такой страницы, нужно доработать правило, на которое указывает валидатор. Если в файле имеются синтаксические ошибки, то валидатор также об этом сообщит.

Генератор robots.txt - создание в режиме онлайн

Если изучать синтаксис желания или времени нет, но необходимость закрыть спамные страницы сайта присутствует, то можно воспользоваться любым бесплатным онлайн генератором , который позволит создать robots txt для сайта всего парой кликов. Затем вам останется лишь скачать файл и загрузить его к себе на сайт. При работе с ним вам лишь необходимо проставить галочки у очевидных настроек, а также указать страницы, которые вы хотите закрыть от индексации. Остальное генератор сделает за вас.

Готовые файлы для популярных CMS

Файл robots.txt для сайта на 1C Битрикс

User-Agent: *

Disallow: /bitrix/

Disallow: /personal/

Disallow: /upload/

Disallow: /*login*

Disallow: /*auth*

Disallow: /*search

Disallow: /*?sort=

Disallow: /*gclid=

Disallow: /*register=

Disallow: /*?per_count=

Disallow: /*forgot_password=

Disallow: /*change_password=

Disallow: /*logout=

Disallow: /*back_url_admin=

Disallow: /*print=

Disallow: /*backurl=

Disallow: /*BACKURL=

Disallow: /*back_url=

Disallow: /*BACK_URL=

Disallow: /*ADD2BASKET

Disallow: /*ADD_TO_COMPARE_LIST

Disallow: /*DELETE_FROM_COMPARE_LIST

Disallow: /*action=BUY

Disallow: /*set_filter=y

Disallow: /*?mode=matrix

Disallow: /*?mode=listitems

Disallow: /*openstat

Disallow: /*from=adwords

Disallow: /*utm_source

Host: www.site.ru

Robots.txt для DataLife Engine (DLE)

User-agent: *

Disallow: /engine/go.php

Disallow: /engine/download.php

Disallow: /engine/classes/highslide/

Disallow: /user/

Disallow: /tags/

Disallow: /newposts/

Disallow: /statistics.html

Disallow: /*subaction=userinfo

Disallow: /*subaction=newposts

Disallow: /*do=lastcomments

Disallow: /*do=feedback

Disallow: /*do=register

Disallow: /*do=lostpassword

Disallow: /*do=addnews

Disallow: /*do=stats

Disallow: /*do=pm

Disallow: /*do=search

Host: www.site.ru

Sitemap: http://www.site.ru/sitemap.xml

Robots.txt для Joomla

User-agent: *

Disallow: /administrator/

Disallow: /cache/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /libraries/

Disallow: /media/

Disallow: /modules/

Disallow: /plugins/

Disallow: /templates/

Disallow: /tmp/

Disallow: /xmlrpc/

Disallow: *print

Disallow: /*utm_source

Disallow: /*mailto*

Disallow: /*start*

Disallow: /*feed*

Disallow: /*search*

Disallow: /*users*

Host: www.site.ru

Sitemap: http://www.site.ru/sitemap.xml

Robots.txt для Wordpress

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: */trackback

Disallow: */feed

Disallow: /wp-login.php

Disallow: /wp-register.php

Host: www.site.ru

Sitemap: http://www.site.ru/sitemap.xml

Robots.txt для Ucoz

User-agent: *

Disallow: /a/

Disallow: /stat/

Disallow: /index/1

Disallow: /index/2

Disallow: /index/3

Disallow: /index/5

Disallow: /index/7

Disallow: /index/8

Disallow: /index/9

Disallow: /panel/

Disallow: /admin/

Disallow: /secure/

Disallow: /informer/

Disallow: /mchat

Disallow: /search

Disallow: /shop/order/

Disallow: /?ssid=

Disallow: /google

Disallow: /

Как настроить корректную индексацию сайта поисковыми роботами? Как закрыть доступ сканирующих роботов к техническим файлам сайта?

Файл robots.txt ограничивает доступ поисковых роботов к файлам на сервере - в файле написаны инструкции для сканирующих роботов. Поисковый робот проверяет возможность индексации очередной страницы сайта - есть ли подходящее исключение. Чтобы поисковые роботы имели доступ к robots.txt, он должен быть доступен в корне сайта по адресу mysite.ru/robots.txt .

Пример полного доступа на индексацию сайта без ограничений:

User-agent: *

Allow: /

Применение в SEO

По умолчанию поисковые роботы сканируют все страницы сайта, к которым они имеют доступ. Попасть на страницу поисковый робот может из карты сайта, ссылки на другой странице, наличии трафика на данной странице и т.п.. Не все страницы, которые были найден поисковым роботом следует показывать в результатах поиска.

Файл robots.txt позволяет закрыть от индексации дубли страниц, технические файлы, страницы фильтрации и поиска. Любая страница на сайте может быть закрыта от индексации, если на это есть необходимость..

Правила синтаксиса robots.txt

Логика и структура файла robots.txt должны строго соблюдаться и не содержать лишних данных:

- Любая новая директива начинается с новой строки.

- В начале строки не должно быть пробелов.

- Все значения одной директивы должны быть размещены на этой же строке.

- Не использовать кавычки для параметров директив.

- Не использовать запятые и точки с запятыми для указания параметров.

- Все комментарии пишутся после символа #.

- Пустая строка обозначает конец действия текущего User-agent.

- Каждая директива закрытия индексации или открытия содержит только один параметр.

- Название файла должно быть написано прописными буквами, файлы Robots.txt или ROBOTS.TXT являются другими файлами и игнорируются поисковыми роботами.

- Если директива относится к категории, то название категории оформляется слешами "/categorya/".

- Размер файла robots.txt не должен превышать 32 кб, иначе он трактуется как разрешающий индексацию всего.

- Пустой файл robots.txt считается разрешающим индексацию всего сайта.

- При указании нескольких User-agent без пустой строки между ними обрабатываться будет только первая

Проверка robots.txt

Поисковые системы Яндекс и Google дают возможность проверить корректность составления robots.txt:

- В Вебмастер.Яндекс - анализ robots.txt .

- В Google Search Console - ссылка , необходимо сначала добавить сайт в систему.

Примеры настройки robots.txt

Первой строкой в robots.txt является директива, указывающая для какого робота написаны исключения.

Директива User-agent

# Все сканирующие роботыUser-agent: *

# Все роботы Яндекса

User-agent: Yandex

# Основной индексирующий робот Яндекса

User-agent: YandexBot

# Все роботы Google

User-agent: Googlebot

Все директивы следующие ниже за User-agent распространяют свое действие только на указанного робота. Для указания данных другому роботу следует еще раз написать директиву User-agent. Пример с несколькими User-agent:

Использование нескольких User-agent

# Будет использована основным роботом ЯндексаUser-agent: YandexBot

Disallow: *request_* # Будет использована всеми роботами Google

User-agent: Googlebot

Disallow: *elem_id* # Будет использована всеми роботами Mail.ru

User-agent: Mail.Ru

Allow: *SORT_*

Сразу после указания User-agent следует написать инструкции для выбранного робота. Нельзя указывать пустые сроки между командами в robots.txt, это будет не правильно понято сканирующими роботами.

Разрешающие и запрещающие директивы

Для запрета индексации используется директива "Disallow", для разрешения индексации "Allow":

User-agent: *

Allow: /abc/

Disallow: /blog/

Указано разрешение на индексацию раздела /abc/ и запрет на индексацию /blog/. По умолчанию все страницы сайта разрешены на индексацию и не нужно указывать для всех папок директиву Allow. Директива Allow необходима при открытии на индексацию подраздела. Например открыть индексацию для подраздела с ужатыми изображениями, но не открывать доступ к другим файлам в папке:

User-agent: *

Disallow: /upload/

Allow: /upload/resize_image/

Последовательность написания директив имеет значение. Сначала закрывается все папка от индексации, а затем открывается её подраздел.

Запрещение индексации - Disallow

Директива для запрета на сканирование - Disallow, индексация запрещается в зависимости от параметров, указанных в директиве.

Полный запрет индексации

User-agent: *Disallow: /

Сайт закрывается от сканирования всех роботов.

Существуют специальные символы "*" и "$", которые позволяют производить более тонкое управление индексацией:

Disallow: /cat*

Disallow: /cat

Символ звездочка означает любое количество любых символов, которые могут идти следом. Вторая директива имеет тот же смысл.

Disallow: *section_id*

Запрещает индексацию всех Url, где встречается значение внутри звездочек.

Disallow: /section/

Закрывает от индексации раздел и все вложенные файлы и подразделы.

Разрешение индексации - Allow

Задача директивы Allow открывать для индексации url, которые подходят под условие. Синтаксис Allow сходен с синтаксисом Disallow.

User-agent: *

Disallow: /

Allow: /fuf/

Весь сайт закрыт от индексации, кроме раздел /fuf/.

Директива Host

Данная директива нужна для роботов поисковой системы Яндекс. Она указывает главное зеркало сайта. Если сайт доступен по нескольким доменам, то это позволяет поисковой системе определить дубли и не включать их в поисковый индекс.

User-agent: *

Disallow: /bitrix/

Host: mysite.ru

В файле robots.txt директиву Host следует использовать только один раз, последующие указания игнорируются.

Если сайт работает по защищенному протоколу https, то следует указывать домен с полным адресом:

User-agent: *

Disallow: /bitrix/

Host: https://domain.ru

Директива Sitemap

Для ускорения индексации страниц сайта поисковым роботам можно передать карту сайта в формате xml. Директива Sitemap указывает адрес, по которому карта сайта доступна для скачивания.

User-agent: *

Disallow: /bitrix/

Sitemap: http://domain.ru/sitemap.xml

Исключение страниц с динамическими параметрами

Директива Clean-param позволяет бороться с динамическими дублями страниц, когда содержимое страницы не меняется, но добавление Get-параметра делает Url уникальным. При составлении директивы сначала указывается название параметра, а затем область применения данной директивы:

Clean-param: get1[&get2&get3&get4&..&getN] [Путь]

Простой пример для страницы http://domain.ru/catalog/?&get1=1&get2=2&get3=3. Директива будет иметь вид:

Clean-param: get1&get2&get3 /catalog/

Данная директива будет работать для раздела /catalog/, можно сразу прописать действие директивы на весь сайт:

Clean-param: get1&get2&get3 /

Снижение нагрузки - Crawl-delay

Если сервер не выдерживает частое обращение поисковых роботов, то директива Crawl-delay поможет снизить нагрузку на сервер. Поисковая система Яндекс поддерживает данную директиву с 2008 года .

User-agent: *

Disallow: /search/

Crawl-delay: 4

Поисковый робот будет делать один запрос, затем ждать 4 секунды и снова делать запрос.

Типовой robots.txt для сайта на Bitrix

В заключении полноценный файл robots.txt для системы 1С-Битрикс, который включает все типовые разделы:

User-agent: *

Disallow: /bitrix/

Disallow: /admin/

Disallow: /auth/

Disallow: /personal/

Disallow: /cgi-bin/

Disallow: /search/

Disallow: /upload/

Allow: /upload/resize_cache/

Allow: /upload/iblock/

Disallow: *bxajaxid*

Sitemap: http://domain.ru/sitemap.xml

Host: domain.ru

Всем привет! Сегодня я бы хотел Вам рассказать про файл robots.txt . Да, про него очень много чего написано в интернете, но, если честно, я сам очень долгое время не мог понять, как же создать правильный robots.txt. В итоге я сделал один и он стоит на всех моих блогах. Проблем с я не замечаю, robots.txt работает просто великолепно.

Robots.txt для WordPress

А зачем, собственно говоря, нужен robots.txt? Ответ все тот же – . То есть составление robots.txt – это одно из частей поисковой оптимизации сайта (кстати, очень скоро будет урок, который будет посвящен всей внутренней оптимизации сайта на WordPress. Поэтому не забудьте подписаться на RSS , чтобы не пропустить интересные материалы.).

Одна из функций данного файла – запрет индексации ненужных страниц сайта. Также в нем задается адрес и прописывается главное зеркало сайта (сайт с www или без www).

Примечание: для поисковых систем один и тот же сайт с www и без www совсем абсолютно разные сайты. Но, поняв, что содержимое этих сайтов одинаковое, поисковики “склеивают” их. Поэтому важно прописать главное зеркало сайта в robots.txt. Чтобы узнать, какое главное (с www или без www), просто наберите адрес своего сайта в браузере, к примеру, с www, если Вас автоматически перебросит на тот же сайт без www, значит главное зеркало Вашего сайта без www. Надеюсь правильно объяснил.

Было:

Стало (после перехода на сайт, www автоматически удалились, и сайт стал без www):

Так вот, этот заветный, по-моему, правильный robots.txt для WordPress Вы можете увидеть ниже.

Правильный для WordPress

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

User-agent: Yandex

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /tag

Host: сайт

Sitemap: https://сайт/sitemap.xml.gz

Sitemap: https://сайт/sitemap.xml

Все что дано выше, Вам нужно скопировать в текстовой документ с расширением.txt, то есть, чтобы название файла было robots.txt. Данный текстовой документ Вы можете создать, к примеру, с помощью программы . Только, не забудьте, пожалуйста, изменить в последних трех строчках адрес на адрес своего сайта. Файл robots.txt должен располагаться в корне блога, то есть в той же папке, где находятся папки wp-content, wp-admin и др. .

Те, кому же лень создавать данный текстовой файл, можете просто и также там подкорректировать 3 строчки.

Хочу отметить, что в техническими частями, о которых речь пойдет ниже, себя сильно загружать не нужно. Привожу их для “знаний”, так сказать общего кругозора, чтобы знали, что и зачем нужно.

Итак, строка:

User-agent

задает правила для какого-то поисковика: к примеру “*” (звездочкой) отмечено, что правила для всех поисковиков, а то, что ниже

User-agent: Yandex

означает, что данные правила только для Яндекса.

Disallow

Здесь же Вы “засовываете” разделы, которые НЕ нужно индексировать поисковикам. К примеру, на странице у меня идет дубль статей (повторение) с обычными статьями, а дублирование страниц отрицательно сказывается на поисковом продвижении, поэтому, крайне желательно, данные секторы нужно закрыть от индексации, что мы и делаем с помощью этого правила:

Disallow: /tag

Так вот, в том robots.txt, который дан выше, от индексации закрыты почти все ненужные разделы сайта на WordPress, то есть просто оставьте все как есть.

Host

Здесь мы задаем главное зеркало сайта, о котором я рассказывал чуть выше.

Sitemap

В последних двух строчках мы задаем адрес до двух карт сайта, созданные с помощью .

Возможные проблемы

Заходим в раздел Настройки индексирования –> Анализ robots.txt:

Уже там нажимаете на кнопку “Загрузить robots.txt с сайта”, а затем нажимаете на кнопку “Проверить”:

Если Вы увидите примерно следующее сообщение, значит у Вас правильный robots.txt для Яндекса:

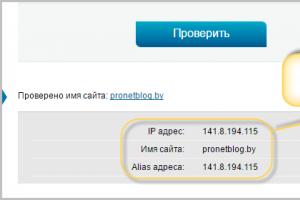

Также Вы можете в “Список URL” добавить адрес любой статьи сайта, чтобы проверить не запрещает ли robots.txt индексирование данной страницы:

Как видите, никакого запрета на индексирование страницы со стороны robots.txt мы не видим, значит все в порядке:).

Надеюсь больше вопросов, типа: как составить robots.txt или как сделать правильным данный файл у Вас не возникнет. В этом уроке я постарался показать Вам правильный пример robots.txt :

До скорой встречи!

P.s. Совсем недавно я , что же интересного произошло? 🙂